如何在你的电脑上运行开源大语言模型(AI)?

我设置了一个完全在我的电脑上运行的AI助手。无需联网。不向云端发送任何数据。

如果你一直好奇如何运行自己的AI,但又认为这需要计算机科学学位,那么我有个好消息要告诉你:这比你想象的要容易。

为什么要使用本地LLM(AI)?

在深入探讨如何操作之前,我们先来谈谈为什么。在本地运行LLM(AI)有一些真正的优势:

- 隐私:您的对话永远不会离开您的计算机。没有任何公司会存储、分析或基于您的数据进行训练。

- 无需互联网:设置完成后,您可以在任何地方使用您的AI:在飞机上、在WiFi信号不佳的咖啡馆里,或者在荒郊野外。

- 免费:初始设置后,没有订阅费或API费用。

- 完全由您掌控:您控制一切。没有速率限制,没有内容过滤器,没有服务条款变更。

您需要什么

以下是我开始所需的东西(您也需要这些):

- 一台相当现代的电脑(Windows、Mac或Linux)

- 大约30分钟的时间

- 大约4-8 GB的可用磁盘空间(取决于您选择的模型)

就是这些。不需要昂贵的GPU,尽管如果您有GPU,运行速度会更快。

什么是llama.cpp?

在深入了解安装过程之前,让我解释一下我们实际上要安装的是什么。

llama.cpp 是一款允许您在计算机上运行大型语言模型(AI)的软件。可以将其视为使一切正常工作的引擎。这些模型只是数据文件,就像视频或音乐文件一样。llama.cpp 是知道如何使用它们的播放器。

它是开源的、免费的,并且正在积极维护中。它适用于Mac、Windows和Linux,并且即使在没有花哨显卡的普通计算机上也能快速运行。

安装

安装llama.cpp最简单的方法是通过包管理器。

如果您使用的是Mac或Linux

打开终端并输入:

brew install llama.cpp这就是安装过程。真的。

如果您使用的是Windows

打开PowerShell并运行:

winget install llama.cpp运行您的第一个AI模型

这是令人兴奋的部分。您无需手动下载模型文件或弄清楚将它们放在哪里。该工具会为您完成所有操作。

以下是启动与AI聊天的命令:

llama-cli -hf bartowski/Llama-3.2-3B-Instruct-GGUF:Q8_0这会从Hugging Face下载并运行Llama 3.2 3B模型。

让我用通俗的语言解释一下这个命令的作用:

llama-cli启动聊天界面-hf告诉它从Hugging Face(一个LLM存储库)下载bartowski/Llama-3.2-3B-Instruct-GGUF:Q8_0是要使用的特定模型

模型标识符包含三个部分,由斜杠和冒号分隔:

bartowski是上传者在Hugging Face上的用户名Llama-3.2-3B-Instruct-GGUF是包含模型的存储库名称Q8_0是特定的量化版本(质量与大小的权衡)

当您运行此命令时,模型会自动下载(首次运行时可能需要几分钟),然后您就可以开始聊天了。输入您的问题,AI就会在您的终端中直接回复。

如何查找和使用不同的模型

我上面提到的模型(Llama 3.2)是一个很好的起点。它相对较小且速度快,即使在普通硬件上也是如此。但还有数百种其他模型可供您尝试。

在Hugging Face上查找模型

GGUF 是llama.cpp使用的文件格式。Hugging Face上的模型有不同的格式,但llama.cpp专门需要GGUF文件。

访问huggingface.co/models并搜索GGUF。寻找名称以-GGUF结尾的存储库。

当您找到想要尝试的模型时,点击它并查找存储库名称。例如,如果您看到bartowski/Qwen2.5-7B-Instruct-GGUF,您可以运行:

llama-cli -hf bartowski/Qwen2.5-7B-Instruct-GGUF:Q8_0选择模型的提示:

- 数字越小 = 速度越快,但能力越弱:3B模型比7B模型快,7B模型比13B模型快。该数字指的是模型的参数量(十亿)。

- 在名称中寻找“Instruct”或“Chat”:这些模型专门针对对话进行了训练。

- :Q8_0 部分:这是量化级别。Q8_0是质量和大小的良好平衡。Q4_0更小/更快,但质量略低。

更进一步:运行AI服务器

一旦您熟悉了基本聊天,就可以通过将AI作为服务器运行来升级。这允许您通过Web浏览器与其聊天,并将其用于其他应用程序。

运行此命令:

llama-server -hf bartowski/Llama-3.2-3B-Instruct-GGUF:Q8_0您将看到类似以下的输出:

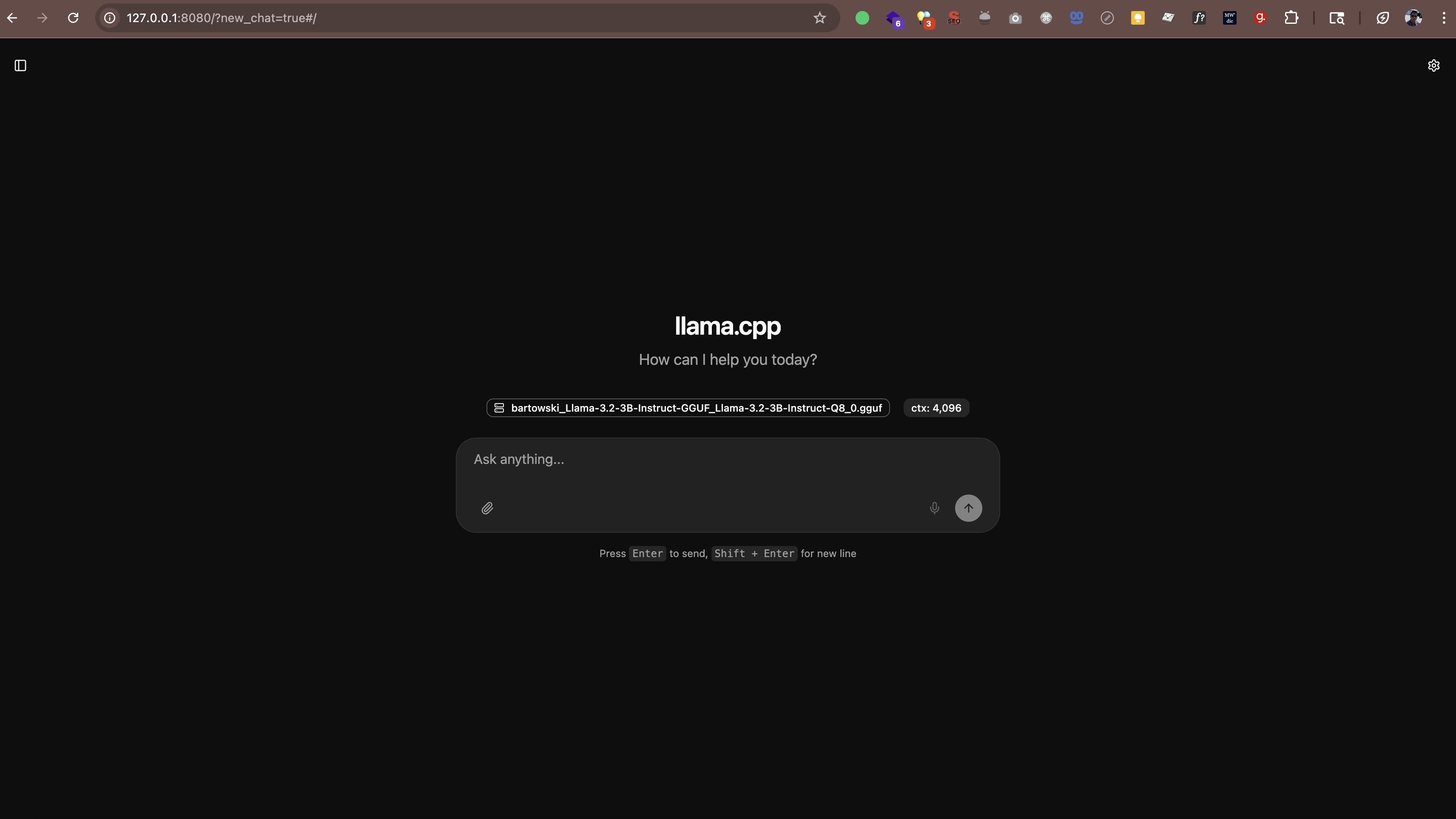

main: server is listening on http://127.0.0.1:8080 - starting the main loop现在在您的Web浏览器中打开http://127.0.0.1:8080(或http://localhost:8080)。您将看到一个聊天界面,您可以在其中直接从浏览器与AI对话。无需额外软件。

该服务器还可与任何支持OpenAI API格式的应用程序配合使用。这意味着您可以使用以下工具:

- Continue.dev(VS Code中的AI编码助手)

- Open WebUI(类似ChatGPT的界面)

- 任何支持自定义API端点的其他应用程序

模型存储在哪里

当您运行这些命令时,模型会自动下载到缓存文件夹中。默认情况下,它位于您的主目录下的.cache/llama.cpp中。

如果您想更改模型的存储位置,可以设置一个环境变量:

# 在Mac/Linux上

export LLAMA_CACHE=/path/to/your/cache

# 在Windows (PowerShell)上

$env:LLAMA_CACHE="C:\path\to\your\cache"性能如何?

以下是我对性能的了解:

- 在较新的Mac(M1/M2/M3/M4)上:模型运行速度非常快。M系列芯片具有内置的AI加速功能。

- 在带有不错GPU的Windows/Linux上:也很快。如果您有NVIDIA GPU,llama.cpp会自动使用它。

- 在没有GPU的旧电脑或笔记本电脑上:仍然可用!只需坚持使用较小的模型(3B或7B),并期望响应速度较慢。

作为参考,在我的M4 Pro(48GB RAM)上,一个3B模型以大约每秒60-65个token的速度生成文本。这快到足以让人感觉像是一次真正的对话。

llama.cpp与Ollama与vLLM的比较

您可能听说过Ollama或vLLM等其他工具。以下是它们的比较方式:

Ollama

Ollama 构建在llama.cpp之上。它增加了更简单的界面和自动模型管理,但这种便利是以性能开销为代价的。在我使用48GB RAM的M4 Pro Mac上的测试中,llama.cpp运行相同模型的速度比Ollama快一个数量级。

如果您追求极致性能,并且不介意使用命令行,请坚持使用llama.cpp。如果您更喜欢简单的模型管理,并且可以接受稍慢的速度,Ollama也能很好地工作。

vLLM

vLLM 不支持macOS。它仅限Linux,专为具有多个GPU的高吞吐量服务器部署而设计。如果您使用的是Mac,它就不是一个选项。

底线

对于Mac用户,尤其是Apple Silicon(M1/M2/M3/M4)用户来说,llama.cpp是最佳选择。它是最快的选项,并具有原生的Metal加速功能。如果您想要更简单的管理,Ollama也不错。vLLM在Mac上不可用。

您可能有的问题

这合法吗?

是的。Hugging Face上的模型是开源的,可以免费使用。许多模型由Meta(Facebook)、Mistral AI和其他明确允许个人和商业用途的组织发布。

这会减慢我的电脑速度吗?

当AI运行时,它会使用CPU/GPU资源。但当您关闭它时,一切都会恢复正常。这就像运行任何其他应用程序一样。

我可以在工作中使用它吗?

这取决于您公司的工作政策。由于所有内容都在本地运行,并且您的数据不会离开您的机器,因此它通常比云AI更安全。但请先与您的IT部门核实。

我需要联网吗?

只需要下载模型时才需要联网。之后,所有内容都可以完全离线工作。

我的体验

我一直在使用我的本地AI,我印象深刻。它的能力还不能完全与GPT-5、Claude Sonnet 4.5或Gemini 2.5匹敌,但对于许多任务(撰写电子邮件、集思广益、回答问题)来说,它绰绰有余。

我最欣赏的是隐私方面。我的对话都保留在我的机器上。没有数据发送到外部服务器。没有训练数据集被输入到别处。这使得它在处理机密信息方面比云AI更适合,尽管您仍应遵守您组织的安保政策。

它完美吗?不。如果我运行一个较大的模型,响应有时会变慢。而且质量还未达到顶级云AI的水平。但是,对于一个免费、私密、随时可用的助手来说?我接受这种权衡。